在当今数据驱动的商业环境中,数据分析已成为企业决策的核心。而数据分析的起点与质量,很大程度上取决于其数据来源与处理方式。本文将深入解析数据分析中的两个关键概念:接口数据源与数据处理服务,阐明它们是什么、如何工作以及为何至关重要。

一、 接口数据源:数据的“高速公路”入口

1. 核心定义

接口数据源,简而言之,是数据分析系统通过标准化协议(如API、Web Service、JDBC/ODBC等)从外部系统实时或定期获取数据的通道。它不是一个静态的数据文件或数据库表,而是一个动态的、程序化的数据接入点。

2. 主要类型与特点

API接口:目前最常见的形式,尤其是RESTful API和GraphQL。它允许系统通过HTTP请求(GET、POST等)从第三方服务(如社交媒体平台、支付网关、SaaS应用)直接拉取结构化数据(通常是JSON或XML格式)。特点是灵活、实时性强,但通常有调用频率限制。

数据库接口:通过JDBC、ODBC等标准协议直接连接业务数据库(如MySQL、Oracle、SQL Server)。适用于需要分析企业内部核心业务数据的场景,数据量大且结构稳定。

消息队列接口:如Kafka、RabbitMQ等。用于接收实时流数据,适用于监控、日志分析、实时风控等对时效性要求极高的场景。

文件传输接口:通过FTP、SFTP或云存储服务(如AWS S3、阿里云OSS)的API获取批量数据文件(如CSV、Parquet)。

3. 在数据分析中的作用

接口数据源打破了数据孤岛,使得分析系统能够:

- 集成多源数据:将来自CRM、ERP、网站、App、物联网设备等不同来源的数据汇聚一堂。

- 获取实时数据:支持对实时业务指标(如在线交易额、用户活跃度)进行监控与分析。

- 自动化数据摄入:替代传统手动导出/导入,实现数据流程的自动化与可重复性。

二、 数据处理服务:数据的“炼油厂”

1. 核心定义

数据处理服务是一系列用于对原始数据(特别是从接口获取的数据)进行加工、转换、清洗和组织的工具、平台或代码流程的总称。它的目的是将杂乱、原始的“原油”数据,提炼成干净、统一、适合分析的“成品油”数据。

2. 关键处理环节

一个完整的数据处理服务通常包含以下环节:

- 数据抽取:从接口数据源等地方拉取数据。

- 数据清洗:处理缺失值、异常值、格式不一致、重复记录等问题。

- 数据转换:进行格式转换(如时间戳标准化)、字段计算、数据聚合、维度退化等。

- 数据加载:将处理后的数据写入目标存储,如数据仓库(如Snowflake、BigQuery)、数据湖或分析数据库。这个过程常被称为 ETL 或 ELT。

3. 常见形态

可视化ETL/ELT工具:如Apache NiFi、Talend、Informatica、阿里的DataWorks等,提供图形化界面配置数据处理流程。

代码/脚本驱动:使用Python(Pandas、PySpark)、SQL或Scala(Spark)编写数据处理脚本,灵活性最高。

云原生数据处理服务:如AWS Glue、Azure Data Factory、Google Cloud Dataflow,提供全托管、可扩展的数据处理能力。

流处理引擎:如Apache Flink、Spark Streaming,专门用于处理实时接口流入的数据流。

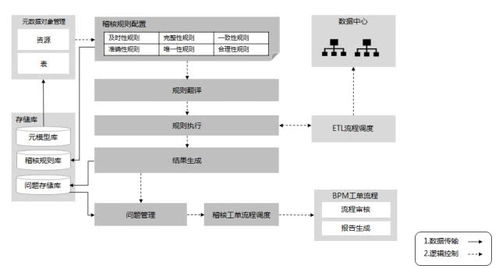

三、 协同工作流:从接口到洞察

在实际的数据分析项目中,接口数据源与数据处理服务紧密协作,形成一个高效的数据流水线:

- 触发与拉取:调度系统(如Airflow)或实时监听器触发任务,通过预定义的接口向目标系统请求数据。

- 原始数据落地:获取的原始数据通常先被持久化到“数据湖”或暂存区,保留原始快照以备审计和重处理。

- 加工处理:数据处理服务启动,对原始数据进行清洗、转换、关联和聚合,使其符合分析模型的要求。

- 服务与存储:处理后的高质量数据被加载到数据仓库或数据集市,结构化为易于查询的星型/雪花模型。

- 分析与应用:BI工具(如Tableau、FineBI)、数据应用或AI模型从处理后的数据中获取洞察,驱动决策。

四、 关键考量与最佳实践

- 稳定性与监控:接口可能不稳定或变更,数据处理流程可能失败。必须建立完善的日志、监控和告警机制。

- 数据质量:在数据处理阶段建立数据质量校验规则(如唯一性、非空、值域检查),从源头保障分析结果的可靠性。

- 性能与成本:接口调用频次、数据量大小直接影响处理速度和云服务成本。需要优化调度策略和处理逻辑。

- 安全与合规:接口认证(API Key、OAuth)、数据传输加密、敏感数据脱敏是必须遵守的安全底线。

###

接口数据源是数据分析的“源头活水”,决定了你能获得什么样的原材料;而数据处理服务是核心的“加工引擎”,决定了原材料的品质和可用性。理解并熟练运用这两者,是构建可靠、高效、可扩展的数据分析体系的基础。在现代数据架构中,它们正朝着实时化、自动化、智能化的方向不断演进,持续赋能数据价值的高效释放。